認知ロボティクス班

研究テーマ

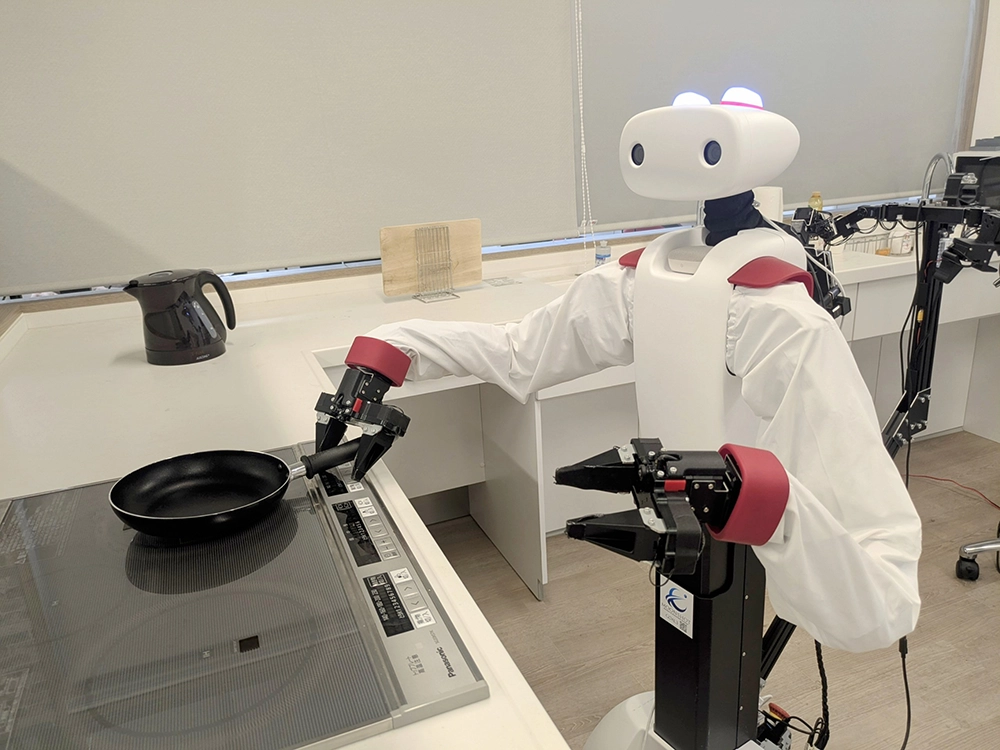

人間の認知機能に基づき、汎用的な動作を可能とするロボットの開発

研究概要

少子高齢化や労働力不足の進行に伴い、家庭内作業を代替・支援できるロボット技術への社会的ニーズが高まっています。こうしたニーズに応えるためには、調理や洗濯などの複雑かつ多様なタスクに柔軟に対応可能な、汎用的な動作生成能力を備えたロボットの実現が求められます。

認知ロボティクス班では、「予測符号化理論」に着想を得た動作生成モデルを用い、より人間らしい認知機能を持つロボットの開発に取り組んでいます。人間の脳は、感覚入力と予測の誤差を最小化することで情報処理を行っているとされており、本研究ではその理論に基づき、ボトムアップ処理(感覚入力)とトップダウン処理(予測・意図)を統合する深層予測学習モデルを構築しています。このモデルにより、対象物の複雑な操作や状況変化に適応した柔軟な動作を実現します。

具体的には、形状が変化しやすい衣類の操作や、加熱や攪拌によって状態が変化する調理中の食材の取り扱いなどを対象としています。これらのタスクでは、対象物の形状、色、温度などに応じて適切な動作を生成する必要があります。また現在は、ロボットの視野を適応的に制御する機構、動作予測の不確実性を考慮した意思決定、双腕による協調動作の生成といったテーマにも取り組んでいます。

本研究は、基幹理工学部 表現工学科 尾形哲也研究室の動作生成班と連携し、先端的なロボット知能の実現を目指して推進されています。

成果・発表(学会発表・論文等)

受賞

- Namiko Saito, Joao Moura and Sethu Vijayakumar, “Long-horizon Manipulation through Hierarchical Motion Planning with Subgoal Prediction,” Proc. 40th Anniversary of the IEEE Conference on Robotics and Automation (ICRA@40), Rotterdam, Netherlands, 2024. Travel Grant

- Namiko Saito, Takumi Shimizu, Tetsuya Ogata and Shigeki Sugano, “Utilization of Image/Force/Tactile Sensor Data for Object-Shape-Oriented Manipulation: Wiping Objects With Turning Back Motions and Occlusion,” in IEEE Robotics and Automation Letters, vol. 7, no. 2, pp. 968-975, 2022, doi: 10.1109/LRA.2021.3136657. (IF: 3.741)

Presented in 2022 International Conference on Robotics and Automation (ICRA 2022), 2022. (in Philadelphia, the USA) Travel Award - Namiko Saito, Tetsuya Ogata, Satoshi Funabashi, Hiroki Mori and Shigeki Sugano, “How to select and use tools? : Active Perception of Target Objects Using Multimodal Deep Learning,” In the IEEE Robotics and Automation Letters (RA-L), vol. 6, no. 2, pp. 2517-2524, April 2021, doi: 10.1109/LRA.2021.3062004. (IF: 3.608), (arxiv.org/abs/2106.02445)

Presented in 2021 International Conference on Robotics and Automation (ICRA 2021), 2021. (in Xi’an, China (virtual-online), Acceptance rate 43.59%, Best Paper Award of Cognitive Robotics)

国際学会

- Riko Kawata, Hyogo Hiruma, Hiroshi Ito, Tetsuya Ogata, Shigeki Sugano: Grasping Motion Generation for Deformable Objects under Dynamic Position Changes via Variance Prediction, the 2026 IEEE/SICE International Symposium on System Integration (SII), 2026.

- Namiko Saito, Mayu Tatsumi, Ayuna Kubo, Kanata Suzuki, Hiroshi Ito, Shigeki Sugano, and Tetsuya Ogata, “Learning Multimodal Attention for Manipulating Deformable Objects with Changing States,” In Proceedings of the IEEE-RAS 24th International Conference on Humanoid Robots (Humanoids 2025), 2025.

- Tamon Miyake, Namiko Saito, Tetsuya Ogata, Yushi Wang, Shigeki Sugano, “Deep Predictive Learning with Proprioceptive and Visual Attention for Humanoid Robot Repositioning Assistance,” In Proceedings of 2025 IEEE/RAS International Conference on Intelligent Robots and Systems (IROS 2025), 2025 (in Hangzhou, China, acceptance rate 46%)

- Namiko Saito, Kiyoshi Yoshinaka, Shigeki Sugano and Ryosuke Tsumura, “Autonomous scanning motion generation adapted to individual differences in abdominal shape for robotic fetal ultrasound,” Advanced Robotics, 38:3, pp.182–191, 2024.

- Tamon Miyake, Tetsuya Ogata, Namiko Saito, Riko Kawata, Takuma Tsukakoshi, Masaki Yoshikawa, Shunsuke Aoki, Takumi Akaishi, Yushi Wang, Shigeki Sugano, “AIREC: Demonstration of AI-driven Robot for Embrace and Care Working in a Domestic Environment,” Proc. 40th Anniversary of the IEEE Conference on Robotics and Automation (ICRA@40), Rotterdam, Netherlands, 2024.

- Namiko Saito, Joao Moura, Tetsuya Ogata, Marina Y. Aoyama, Shingo Murata, Shigeki Sugano, and Sethu Vijayakumar, “Structured Motion Generation with Predictive Learning: Proposing Subgoal for Long-Horizon Manipulation,” In Proceedings of 2023 IEEE International Conference on Robotics and Automation (ICRA 2023), pp. 9566-9572, 2023. (in London, U.K., acceptance rate: 43.04%,)

- Namiko Saito, Takumi Shimizu, Tetsuya Ogata, and Shigeki Sugano: Utilization of Image/Force/Tactile Sensor Data for Object-shape-oriented Manipulation, Proceedings of 2022 IEEE International Conference on Robotics and Automation (ICRA 2022), accepted, (acceptance rate 43.1%), Philadelphia, USA, May 23 – 27, 2022. ICRA 2022 Travel Grant

- Namiko Saito, Tetsuya Ogata, Hiroki Mori, Shingo Murata and Shigeki Sugano, “Tool-use Model to Reproduce the Goal Situations Considering Relationship among Tools, Objects, Actions and Effects Using Multimodal Deep Neural Networks,” Frontiers in Robotics and AI, vol. 8, September, 2021. (IF: 4.33)

- Namiko Saito, Dangyang Wang, Tetsuya Ogata, Hiroki Mori and Shigeki Sugano, “Wiping 3D-objects using Deep Learning Model based on Image/Force/Joint Information,” In Proceedings of the IEEE International Conference on Intelligent Robots and Systems (IROS 2020), pp. 10152-10157, 2020. (in Las Vegas, the USA (online), Acceptance rate 47%)

- Namiko Saito, Nguyen Ba Dai, Tetsuya Ogata, Hiroki Mori and Shigeki Sugano,“Realtime Liquid Pouring Motion Generation: End-to-End Sensorimotor Coordination for Unknown Liquid Dynamics Trained with Deep Neural Networks,” In Proceedings of the IEEE International Conference on Robotics and Biomimetics (ROBIO 2019), pp. 1077-1082, 2019. (in Dali, China, Acceptance rate: 54%)

- Namiko Saito, Kitae Kim, Shingo Murata, Tetsuya Ogata and Shigeki Sugano, “Tool-use Model Considering Tool Selection by a Robot using Deep Learning,” In Proceedings of the 2018 IEEE-RAS 18th International Conference on Humanoid Robots (Humanoids 2018), pp. 270-276, 2018. (in Beijing, China, Acceptance rate for oral presentation was 19.5%)

- Namiko Saito, Kitae Kim, Shingo Murata, Tetsuya Ogata and Shigeki Sugano, “Detecting Features of Tools, Objects, and Actions from Effects in a Robot using Deep Learning,” In Proceeding of IEEE International Conference on Development and Learning and on Epigenetic Robotics (ICDL-Epirob 2018), pp. 1-6, 2018. (in Tokyo, Japan)

国内学会

- 青木駿介, 鹿田玄輝, 伊藤洋, 尾形哲也, 菅野重樹: 階層型深層予測学習モデルを用いた双腕協調動作の生成, 日本機械学会ロボティクスメカトロニクス講演会, 1P1-N03, 山形ビッグウイング, 2025年6月5日

- 河田璃子, 伊藤洋, 昼間彪吾, 蔡賢博, 尾形哲也, 菅野重樹: 予測分散最小化による動的位置変化を伴う柔軟物体の把持動作生成, 日本機械学会ロボティクスメカトロニクス講演会, 1P1-N01, 山形ビッグウイング, 2025年6月5日

- 久保杏由南, 伊藤洋, Simon Armleder, 尾形哲也, Gordon Cheng, 菅野重樹: ロボット視野の適応的な動きによる作業エリアの拡大と動作性能の向上, 計測自動制御学会システムインテグレーション部門講演会SI2024, 1D7-07, アイーナいわて県民情報交流センター, 2024年12月18日.

- 藤田幸哉, 伊藤洋, 一藁秀行, 斎藤菜美子, 久保杏由南, 尾形哲也, 菅野重樹: マルチモーダル情報を扱う奥行きを考慮した動作生成モデルによる柔軟物操作の精度向上, 第38回人工知能学会全国大会, 3O1-OS-16b-03, アクトシティ浜松+オンライン, 2024年5月30日.

- 久保杏由南, 斎藤菜美子, 鈴木彼方, 伊藤洋, 尾形哲也, 菅野重樹: 対象物の特徴の共有による複数タスク動作生成のための深層学習モデル, 日本機械学会ロボティクスメカトロニクス講演会,2A1-H05, 2023年6月30日.

- 平本万結, 斉藤菜美子, 尾形哲也, 菅野重樹: 料理ロボットのための注意機構を用いたリアルタイム能動知覚モデル-食材の特徴に応じた料理のかき混ぜ動作の実現-, 情報処理学会第84回全国大会,4V-08,愛媛大学,2022年3月4日.学生奨励賞

- 清水拓実,斎藤菜美子,尾形哲也,菅野重樹:触覚/運動情報を用いた立体オブジェクトにおける拭き取り動作の学習,情報処理学会第83回全国大会,2Q-04,オンライン,2021年3月18日.

- 樋園翼,斎藤菜美子,森裕紀,村田真悟,出井勇人,尾形哲也,菅野重樹:RNNを用いた予測不確実性と予測変化に基づく好奇心による行動選択モデルの提案, 日本発達神経科学会第9回学術集会, 2020.

- 小栗滉貴,庄野修,斎藤菜美子,尾形哲也,菅野重樹:3DCNN と Temporal Skip Connection を利用したビデオ予測モデルの提案と評価,日本ロボット学会第38回学術講演会, 1B1-01, オンライン, 2020年10月9日.

- 斎藤菜美子,尾形哲也,森裕紀,菅野重樹:料理ロボットのための道具使用深層学習モデル-食材の能動知覚に基づく道具の選択と使いこなし,日本機械学会ロボティクスメカトロニクス講演会,1P1-G03, 2020年5月28日.

- 斎藤菜美子,呉雨恒,尾形哲也,森裕紀,王丹阳,陽品駒,菅野重樹:料理ロボットのための道具の選択・使用深層学習モデル – 道具と食材の配置に応じた料理のよそい動作の実現,情報処理学会第82回全国大会,5U-08,金沢工業大学,2020年3月6日.

- 王丹陽,斎藤菜美子,尾形哲也,菅野重樹:深層学習を用いたロボットによる複雑形状対象の拭き取りタスクモデルの構築,情報処理学会第82回全国大会,5U-09,金沢工業大学,2020年3月6日. 学生奨励賞

- Dai Ba Nguyen, Namiko Saito, Tetsuya Ogata, and Shigeki Sugano, “Liquid Estimation Model for Robot Pouring Skill using Active Motion and Deep Learning,” the 36th conference of the The Robotics Society of Japan, 2018.

- Namiko Saito, Kitae Kim, Dai Ba Nguyen, Shingo Murata, Tetsuya Ogata and Shigeki Sugano, “Tool-use Model Considering Selecting Tool by Deep Learning,” the 32th Annual Conference of the Japanese Society for Artificial Intelligence, 2018.

- 斎藤菜美子,金杞泰,村田真悟,尾形哲也,菅野重樹:深層学習を用いた道具と物体の関係性を考慮した道具使用モデル,日本機械学会ロボティクスメカトロニクス講演会,1A1-D07,2018年6月4日.